Viele Menschen experimentieren bereits mit generativen neuronalen Netzwerken und setzen sie regelmäßig ein, auch am Arbeitsplatz. So werden beispielsweise ChatGPT und ähnliche Tools von fast 60 % der Amerikaner regelmäßig verwendet (und dies nicht immer mit Genehmigung des Arbeitgebers). Allerdings werden alle Daten, die bei diesen Vorgängen verarbeitet werden (sowohl Benutzereingaben als auch Musterantworten), auf den Servern von OpenAI, Google und anderen Anbietern gespeichert. Für Aufgaben, bei denen ein solcher Informationsleck inakzeptabel ist, musst du dennoch nicht vollständig auf KI verzichten – du musst lediglich ein wenig Mühe (und möglicherweise Geld) investieren, um das neuronale Netzwerk lokal auf deinem eigenen Computer – sogar auf einem Laptop – zu betreiben.

Cloud-Bedrohungen

Die beliebtesten KI-Assistenten laufen in der Cloud-Infrastruktur großer Unternehmen. Das ist effizient und schnell, aber deine vom Modell verarbeiteten Daten können sowohl für den KI-Dienstleister als auch für völlig unabhängige Parteien zugänglich sein, wie es letztes Jahr bei ChatGPT der Fall war.

Je nachdem, wofür diese KI-Assistenten verwendet werden, stellen solche Vorfälle unterschiedliche Bedrohungsstufen dar. Wenn du niedliche Illustrationen für Märchen erstellst, die du geschrieben haben, oder ChatGPT bittest, einen Reiseplan für deine bevorstehende Wochenend-Städtereise zu erstellen, ist es unwahrscheinlich, dass ein Leck zu ernsthaften Schäden führt. Wenn deine Unterhaltung mit einem Chatbot jedoch vertrauliche Informationen wie persönliche Daten, Passwörter oder Bankkartennummern enthält, ist es nicht akzeptabel, dass diese Daten in der Cloud landen. Zum Glück lässt sich dies relativ einfach verhindern, indem die Daten vorab gefiltert werden – dazu haben wir einen separaten Beitrag geschrieben.

In Fällen, in denen entweder die gesamte Korrespondenz vertraulich ist (z. B. medizinische oder finanzielle Informationen) oder die Zuverlässigkeit der Vorfilterung fraglich ist (du musst große Datenmengen verarbeiten, die niemand in der Vorschau anzeigen und filtern kann), gibt es nur eine Lösung: Die Verarbeitung aus der Cloud auf einen lokalen Computer verschieben. Natürlich ist es unwahrscheinlich, dass es dir gelingen wird, deine eigene Version von ChatGPT oder Midjourney offline auszuführen, aber andere lokal arbeitende neuronale Netzwerke bieten eine vergleichbare Qualität bei geringerer Rechenlast.

Welche Hardware wird für den Betrieb eines neuronalen Netzwerks benötigt?

Du hast wahrscheinlich gehört, dass die Arbeit mit neuronalen Netzwerken superstarke Grafikkarten erfordert, aber in der Praxis ist dies nicht immer der Fall. Verschiedene KI-Modelle können je nach Spezifizierung Computerkomponenten wie Arbeitsspeicher, Grafikspeicher, Laufwerk und CPU einiges abverlangen (hier ist nicht nur die Verarbeitungsgeschwindigkeit wichtig, sondern auch die Unterstützung des Prozessors für bestimmte Vektorbefehle). Die Möglichkeit, das Modell zu laden, hängt von der Größe des Arbeitsspeichers ab, und die Größe des „Kontextfensters“ – d. h. des Speichers der vorherigen Konversation – hängt von der Größe des Grafikspeichers ab. Bei einer schwachen Grafikkarte und CPU erfolgt die Generierung in der Regel sehr langsam (ein bis zwei Wörter pro Sekunde bei Textmodellen), sodass ein Computer mit so einer Minimalkonfiguration nur geeignet ist, um sich mit einem bestimmten Modell vertraut zu machen und seine grundsätzliche Eignung zu bewerten. Für einen vollwertigen alltäglichen Gebrauch musst du den Arbeitsspeicher erweitern, die Grafikkarte aufrüsten oder ein schnelleres KI-Modell wählen.

Als Ausgangspunkt kannst du Computer verwenden, die 2017 als relativ leistungsstark galten und mindestens mit einem Core i7-Prozessor mit Unterstützung für AVX2-Anweisungen, 16 GB Arbeitsspeicher und einer Grafikkarte mit mindestens 4 GB Speicher ausgestattet sind. Für Mac-Enthusiasten genügen Modelle, die mit dem Apple M1-Chip oder höher ausgestattet sind. Die Speicheranforderungen sind dieselben.

Bei der Auswahl eines KI-Modells solltest du dich zunächst mit den Systemanforderungen vertraut machen. Eine Suchanfrage wie „Modellname Anforderungen“ hilft dir einzuschätzen, ob es sich angesichts der verfügbaren Hardware lohnt, dieses Modell herunterzuladen. Es gibt ausführliche Studien über die Auswirkungen von Speichergröße, CPU und GPU auf die Leistung verschiedener Modelle, zum Beispiel diese.

Eine gute Nachricht für jene, die keinen Zugriff auf leistungsstarke Hardware haben: Es gibt vereinfachte KI-Modelle, die selbst auf alter Hardware praktische Aufgaben ausführen können. Sogar wenn deine Grafikkarte sehr einfach und schwach ist, besteht die Möglichkeit, Modelle und Startumgebungen nur mit der CPU auszuführen. Je nach Aufgaben können diese sogar recht gut funktionieren.

Die Wahl eines KI-Modells und die Magie der Quantisierung

Heutzutage ist eine Vielzahl von Sprachmodellen verfügbar, aber viele von ihnen haben nur begrenzte praktische Anwendungen. Es gibt jedoch einfach zu bedienende und öffentlich verfügbare KI-Tools, die sich für bestimmte Aufgaben gut eignen, sei es Textgenerierung (z. B. Mistral 7B) oder Erstellung von Code-Schnipseln (z. B. Code Llama 13B). Schränke daher die Auswahl auf einige geeignete Modelle ein und vergewissere dich anschließend, dass dein Computer über die erforderlichen Ressourcen verfügt, um sie auszuführen.

In jedem neuronalen Netzwerk ist der Großteil der Gedächtnisbelastung auf Gewichtungen zurückzuführen – numerische Koeffizienten, die die Funktion jedes Neurons im Netzwerk beschreiben. Beim Training des Modells werden die Gewichtungen zunächst berechnet und als hochgenaue Bruchzahlen gespeichert. Es stellte sich jedoch heraus, dass das Runden der Gewichtungen im trainierten Modell es ermöglicht, das KI-Tool auf normalen Computern auszuführen, wobei die Leistung nur geringfügig verringert wird. Dieser Rundungsvorgang wird als Quantisierung bezeichnet, und damit kann die Größe des Modells erheblich reduziert werden – statt 16 Bit kann jede Gewichtung 8, 4 oder sogar 2 Bit verwenden.

Laut aktuellen Forschungsergebnissen kann ein größeres Modell mit mehr Parametern und Quantisierung manchmal bessere Ergebnisse liefern als ein Modell mit präziser Gewichtsspeicherung, aber weniger Parametern.

Mit diesem Wissen ausgestattet kannst du nun die unzähligen Open-Source-Sprachmodellen erkunden, nämlich die Top-Liste der Open-Source-LLM. In dieser Liste sind die KI-Tools nach verschiedenen Metriken für die Generierungsqualität sortiert, und Filter erleichtern es, zu große, zu kleine oder zu genaue Modelle auszuschließen.

Nachdem du die Beschreibung des Modells gelesen und dich vergewissert hast, dass das Modell voraussichtlich deinen Anforderungen entspricht, kannst du dessen Leistung in der Cloud mithilfe der Dienste Hugging Face oder Google Colab testen. Auf diese Weise kannst du vermeiden, Modelle herunterzuladen, die zu unbefriedigenden Ergebnissen führen, und sparst so Zeit. Wenn du mit dem ersten Test des Modells zufrieden bist, ist es an der Zeit zu sehen, wie es lokal funktioniert!

Erforderliche Software

Die meisten Open-Source-Modelle sind auf Hugging Face veröffentlicht, aber es reicht nicht aus, sie einfach auf deinen Computer herunterzuladen. Um sie auszuführen, musst du eine spezielle Software wie LLaMA.cpp oder – noch einfacher – ihren „Wrapper“ LM Studio installieren. Letzterer ermöglicht es dir, das gewünschte Modell direkt aus dem Programm auszuwählen, es herunterzuladen und in einem Dialogfeld auszuführen.

Eine weitere „sofort einsatzbereite“ Möglichkeit, einen Chatbot lokal zu nutzen, ist GPT4All. Hier ist die Auswahl auf etwa ein Dutzend Sprachmodelle beschränkt, aber die meisten von ihnen laufen sogar auf einem Computer mit nur 8 GB Arbeitsspeicher und einer einfachen Grafikkarte.

Wenn die Generierung zu langsam ist, benötigst du möglicherweise ein Modell mit gröberer Quantisierung (2 statt 4 Bit). Wenn die Generierung unterbrochen wird oder Ausführungsfehler auftreten, liegt das Problem häufig an unzureichendem Speicher – es lohnt sich, nach einem Modell mit weniger Parametern oder mit einer gröberen Quantisierung zu suchen.

Viele Modelle auf Hugging Face wurden bereits mit unterschiedlichen Genauigkeitsgraden quantisiert. Wenn das gewünschte Modell jedoch noch nicht mit der gewünschten Genauigkeit quantisiert wurde, kannst du das mithilfe von GPTQ selbst tun.

Diese Woche wurde ein weiteres vielversprechendes Tool für die öffentliche Beta-Phase freigegeben: Chat With RTX von NVIDIA. Der Hersteller der gefragtesten KI-Chips hat einen lokalen Chatbot auf den Markt gebracht, der in der Lage ist, den Inhalt von YouTube-Videos zusammenzufassen, Dokumentensätze zu verarbeiten und vieles mehr – vorausgesetzt, der Benutzer verfügt über einen Windows-PC mit 16 GB Arbeitsspeicher und einer NVIDIA RTX-Grafikkarte der 30er- oder 40er-Serie mit mindestens 8 GB Grafikspeicher. Der Chatbot basiert auf den Modellen Mistral und Llama 2 von Hugging Face. Natürlich können leistungsstarke Grafikkarten die Generierungsleistung verbessern, aber nach dem Feedback der ersten Tester ist die vorhandene Beta-Version ziemlich umständlich (ca. 40 GB) und schwierig zu installieren. Chat With RTX von NVIDIA könnte sich jedoch in Zukunft zu einem sehr nützlichen lokalen KI-Assistenten entwickeln.

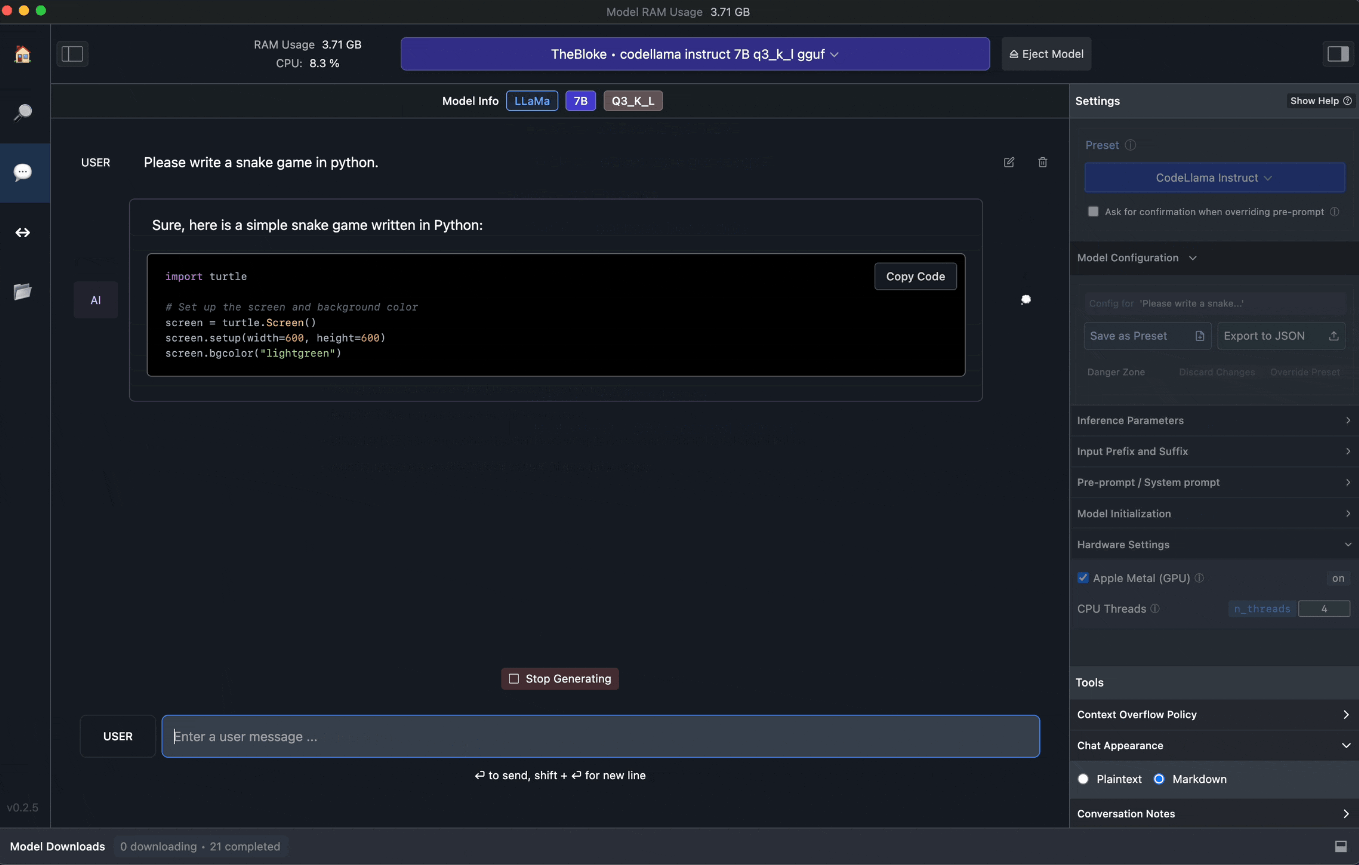

Der Code für das Spiel „Snake“, geschrieben vom quantisierten Sprachmodell TheBloke/CodeLlama-7B-Instruct-GGUF

Die oben aufgeführten Programme führen alle Berechnungen lokal aus, senden keine Daten an Server und können offline ausgeführt werden, damit du vertrauliche Informationen sicher mit ihnen teilen kannst. Um sich jedoch vollständig vor Datenlecks zu schützen, musst du nicht nur die Sicherheit des Sprachmodells, sondern auch die deines Computers gewährleisten – und genau hier setzt unsere umfassende Sicherheitslösung an. Wie in unabhängigen Tests bestätigt wurde, schont Kaspersky Premium die Systemressourcen deines Computers – ein wichtiger Vorteil bei der Arbeit mit lokalen KI-Modellen.

KI

KI

Tipps

Tipps